Marlon-Benedikt George verfasste in Kooperation mit dem Hessischen Institut für Landesgeschichte seine Abschlussarbeit im Masterstudiengang „Cultural Data Studies“ des Marburg Center for Digital Culture and Infrastructure (MCDCI), die von Prof. Dr. Isabelle Borucki ( Politikwissenschaftliche Methoden und Demokratie im digitalen WandelÖffnet sich in einem neuen Fenster, Philipps-Universität Marburg) und Stefan Aumann (HIL) betreut wurde. Sehr gern veröffentlich das HIL seinen Bericht.

Im Rahmen meiner Masterarbeit in den “Cultural Data Studies” habe ich die Protokolle der 20. Legislaturperiode des hessischen Landtags (2019–2024) rechnergestützt analysiert. Die 20. Legislaturperiode fand zeitgeschichtlich in einer Periode statt, die in der Geschichte der Bundesrepublik ihresgleichen sucht. Einige der besonders bedeutsamen und prägenden Ereignisse, die sich während der 20. Legislaturperiode ereigneten oder ihren Anfang nahmen, sind die Covid-19-Pandemie, der Russisch-Ukrainische Krieg, der Anschlag in Hanau und der erstmalige Einzug der AfD in den hessischen Landtag mit 13.1 % der Wählerstimmen. Das Hessische Institut für Landesgeschichte stand mir bei meiner Arbeit tatkräftig zur Seite. Mir wurden die OCR-erkannten Plenarprotokolle in unterschiedlichen Datenformaten zur Verfügung gestellt. Das in einer Kooperation zwischen dem Fachgebiet Hessische Landesgeschichte der Philipps-Universität und dem Hessischen Institut für Landesgeschichte realisierte Portal parlamente.hessen.de diente als wichtige Inspirationsquelle für meine Arbeit. Das Portal appliziert und visualisiert textstatistische Methoden (Termfrequenzanalysen) auf die Plenarprotokolle des hessischen Nachkriegslandtages. Mit meiner Arbeit möchte ich die weiterführende Erschließung dieser wertvollen Quelle mit rezenten Verfahren aus dem Bereich des Text Minings inspirieren und anstoßen. Ich hoffe, dass ich mit der von mir vorgeschlagenen Auszeichnung mit einem von XML-TEI abgeleiteten XML-Schema die maschinenlesbare Strukturierung und Portabilität der Ressource verbessern konnte.

Auf der Grundlage der mir zur Verfügung gestellten Daten habe ich eine Technik aus der Sphäre des Machine Learnings angewandt. Genauer gesagt habe ich das inzwischen weit verbreitete – aber in den Geisteswissenschaften nichtsdestoweniger exotische – Topic Modeling mittels Latent Dirichlet Allocation (LDA) angewandt. Das unüberwachte, maschinelle Lernverfahren LDA geht auf ein im Jahr 2003 von David Blei veröffentlichtes Papier zurück und wird für die Dokumentenklassifikation und die Inhaltsanalyse von großen Textkorpora eingesetzt. Strukturell verwandte Arbeiten, die ebenfalls LDA auf ein Korpus parlamentarischer Prototokolle applizieren, sind etwa “Using Topic Generation Model to explore the French Parliamentary Debates during the early Third Republic (1881-1899)” von Bourgeois et al. oder “The Europeanization of Parliamentary Debates on Migration in Austria, France, Germany, and the Netherlands” von Blätte et al.

Wer die Themenmodellierung mit LDA verwendet, der betrachtet das zu untersuchende Korpus unter einigen Prämissen. Wir nehmen an, dass die Dokumente des Korpus als Kompositionen aus latenten Themen darstellbar sind. Themen im Sinne des Topic Modellings sind dabei Mengen von Termen, die untereinander statistisch assoziiert sind. Das bedeutet, dass sie häufiger in einem Kontext kookkurrieren als andere Termen der Grundgesamtheit. Der Kontext ist frei wählbar und wird durch die Zerlegung des Korpus in kleinere Texteinheiten im Rahmen der Vorverarbeitung determiniert. Im Ergebnis können wir alle Terme mit einer gewissen Wahrscheinlichkeit einem Thema zuordnen, jedem Thema – mit einer gewissen Wahrscheinlichkeit- die Terme des Korpus und jedem Dokument die quantifizierbaren Anteile der Themen, die sie konstituieren.

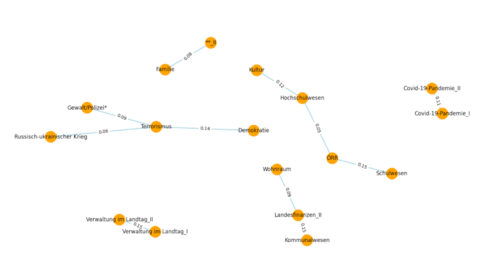

Nachdem das Modell trainiert wurde, konnte ich mit dessen Hilfe einerseits ein Licht auf die Einbettung von politischen Themen – im Sinne der klassischen Bedeutung – werfen und andererseits konnte ich festellen, wie salient die Themen innerhalb der Legislaturperiode waren und wie die Themen untereinander korreliert sind. Besonders interessant sind dabei die Salienz und die Exklusivität der Terme innerhalb der Themen. Auf meinem Data Dashboard, das am Ende dieses Artikels verlinkt ist, können Sie selbst die Visualisierung des Themenmodells erkunden.

Ich möchte betonen, dass LDA erst in Konjunktion mit gewissenhafter, menschlicher Supervision gewinnbringend eingesetzt werden kann. Die identifizierten Themen sind keine Themen im Sinne der Alltagsbedeutung, sondern Termmengen. Die Themen werden erst bedeutsam, wenn sie kritisch beurteilt und ihnen ein Bezeichner von einem menschlichen “Agenten” zugewiesen wird. Darüber hinaus beinhaltet die komplexe Vorverarbeitung der Daten ebenfalls viele qualitative Analyseleistungen, ohne die wir mit Topic Modeling keine nachvollziehbaren Ergebnisse erzeugen können. Dem Programm wird im Rahmen des Text Minings also nicht das Feld überlassen, sondern es fungiert als Werkzeug, das es dem Forscher ermöglicht, innerhalb kurzer Zeit große Textbestände zu erschließen und statistisch zu analysieren, die in angemessener Zeit qualitativ nicht ausgewertet werden können.

Inhaltlich konnte ich ebenfalls einige interessante Zusammenhänge aufdecken. Ich konnte die starke Vernetzung und Verschmelzung der Klima- und Wirtschaftspolitik konstatieren. Dies ergibt vor dem Hintergrund der schwarz-grünen Koalition durchaus ein kongruentes Bild. Weiterhin konnte ich Indizien für die Rahmung des Russisch-Ukrainischen Kriegs als Fluchtursache finden. Ein Narrativ, das zuletzt im Rahmen der ostdeutschen Landtagswahlen eine Konjunktur erlebte. Darüber hinaus habe ich eine besonders saliente Rolle der Migrations- und Integrationspolitik auf der Grundlage der Infratest Dimap Vorwahlbefragung und des starken Abschneidens der AfD antizipiert. Ich konnte diese Erwartung anhand meines Themenmodells nicht bestätigen. Dagegen konnte ich erwartungsgemäß eine ausgeprägte Salienz der Bildungspolitik feststellen, die in der Landespolitik traditionell eine wichtige Rolle spielt, da die Länder in diesem Feld relativ große Kompetenzen haben. Auch politische Großereignisse wie die Covid-19-Pandemie wurden erwartungsgemäß vom Modell erfasst.

Zum Schluss möchte ich noch auf die Limitationen meiner Arbeit hinweisen, die ich ausführlich diskutiert habe. Das Topic Modeling ist eine neuartige Methode in den Geistes- und Sozialwissenschaften. Es existieren keine standardisierten Frameworks und nur wenig fachlich einschlägige, methodische Literatur. Die Reproduzierbarkeit, Vergleichbarkeit und Nachvollziehbarkeit von Ergebnissen sind somit problematisch. Ich habe mich daher um maximale Transparenz in allen Stadien meines Arbeitsprozesses bemüht. Daneben sind Themenmodelle multipel realisierbar durch eine verschiedenartige Vorverarbeitung der Daten oder eine differente Parametrisierung des Modells. Grundsätzlich ergeben sich bei der Arbeit mit natürlicher Sprache Probleme, die sich unter dem Terminus “semantische Unschärfe” zusammenfassen lassen, wie etwas Homonymie, Polysemie oder Synonymie. Weitere Probleme sind die problembehaftete Übertragbarkeit von technischen Erkenntnissen, etwa ingenieurwissenschaftlicher Disziplinen, auf das Feld der Geistes- und Sozialwissenschaften, da hier eigentümliche wissenschaftstheoretische Traditionen und Herausforderungen bestehen.

Ich habe einige Ergebnisse meiner Masterarbeit auf einem Data Dashboard zusammengefasst, das Sie unter https://nolram567.github.io/HesseParlPy/Öffnet sich in einem neuen Fenster abrufen können.